Эффективная адаптация моделей без потери качества

На конференции NeurIPS 2024 представлен революционный подход к дообучению нейросетей. С увеличением размеров моделей их перенастройка становится ресурсоемкой, а обучение с нуля — непрактичным. Ученые сосредоточились на создании экономичных методов, сохраняющих исходные возможности ИИ при адаптации к новым задачам.

Группируй и перемешивай: простота в деталях

Специалисты НИУ ВШЭ и AIRI предложили стратегию группировки параметров — «Group-and-Shuffle». Вместо обработки всего массива данных система делит их на блоки, оптимизирует каждый по отдельности, а затем комбинирует результаты. Это сокращает вычислительные затраты и повышает гибкость настройки, сохраняя компактность структуры.

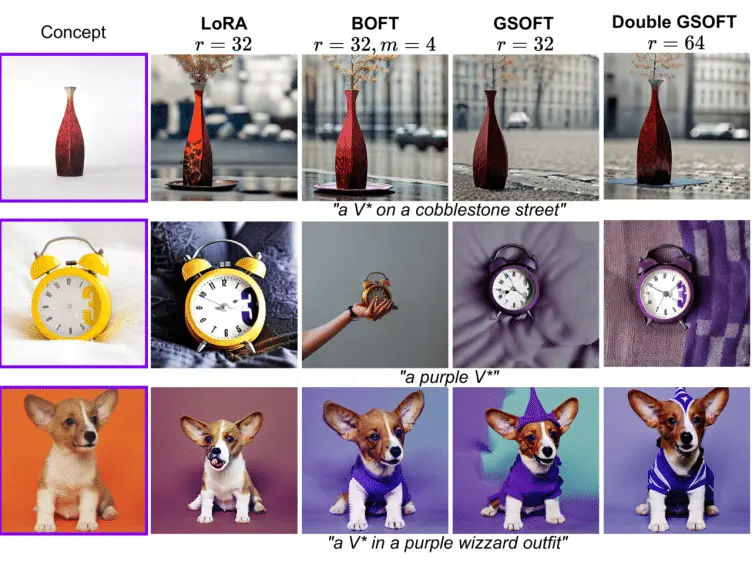

От GS-матриц к Double GSOFT

На основе групповых матриц разработан метод GSOFT, который требует меньше параметров, чем аналоги, но демонстрирует стабильную работу даже с малыми данными. Дополнение в виде Double GSOFT позволяет корректировать модель с двух сторон, увеличивая точность без роста нагрузки на память.

Практические достижения

Тесты на языковой модели RoBERTa показали превосходство GSOFT над конкурентами. В генерации изображений метод обогнал LoRA и BOFT по скорости и качеству, а в сверточных сетях продемонстрировал устойчивость к искажениям. «Наш подход экономит до 80% ресурсов за счет использования всего двух матриц вместо пяти», — подчеркивает Николай Юдин из НИУ ВШЭ.

Универсальность и перспективы

«GSOFT успешно применен в генеративном ИИ, распознавании образов и других областях, — комментирует Айбек Аланов, руководитель группы AIRI. — Это подтверждает, что метод эффективен для разнообразных задач при сниженных затратах». Технология открывает новые возможности для быстрой кастомизации нейросетей без потери их базовых характеристик.

Источник: naked-science.ru